قامت إدارة شرطة مدينة نيويورك على مدى السنوات الست الماضية بتجميع قاعدة بيانات ضخمة لأسماء وتفاصيل شخصية تخص 17,500 فرد على الأقل تعتقد أنهم متورطون في عصابات إجرامية، وتم انتقاد هذه الجهود من قِبل ناشطي الحقوق المدنية بأنها -حسب زعمهم- غير دقيقة، وتتصف بالتمييز العنصري.

وقد قالت شيرلين إيفل (رئيسة صندوق الدفاع القانوني للجمعية الوطنية للنهوض بالملوّنين NAACP والمستشارة الإدارية فيه) خلال ندوة “الذكاء الاصطناعي الآن” التي أقيمت في 16 أكتوبر الماضي في نيويورك: “تخيل الآن أن تقترن تقانة التعرف على الوجوه مع تطوير قاعدة بياناتٍ تفترض نظرياً أنك عضوٌ في عصابة ما”.

يؤكد كلٌّ من المحامين والناشطين والباحثين على الحاجة إلى الأخلاق والمساءلة في عملية تصميم وتنجيز أنظمة الذكاء الاصطناعي، إلا أن هذا الرأي غالباً ما يتجاهل سؤالين مثيرين للجدل: مَن يملك الحق في تعريف هذه الأخلاقيات؟ ومن يفترض به أن يضعها موضع التنفيذ؟

شيرلين إيفل (صندوق الدفاع القانوني للجمعية الوطنية للنهوض بالملوّنين)، تيمنيت جيبرو (جوجل)، ونيكول أوزر (الاتحاد الأميركي للحريات المدنية) في جلسة حوارية خلال ندوة الذكاء الاصطناعي الآن للعام 2018.

لا يقتصر الإشكال على القصور في التعرف على الوجوه؛ إذ كشفت دراساتٌ عن كون البرمجيات الرائدة في هذا المجال أقل دقة في التعرف حين يتعلق الأمر بالأفراد والنساء من ذوي البشرة الملونة. ووفقاً لتقديرات إيفل فإن قاعدة بيانات الشرطة تتضمن بنسبة تتراوح من 95% إلى 99% منها أفراداً أميركيين من أصل أفريقي، ولاتينيين، وأميركيين من أصل آسيوي.

تقول إيفل: “نحن نتحدث عن إنشاء فئة جديدة من الأشخاص (الملونين) يحملون وسوماً تشير إلى أنهم مجرمون”.

وفي الوقت نفسه بدأت إدارات الشرطة في كل من الولايات المتحدة والمملكة المتحدة والصين باعتماد تقنية التعرف على الوجوه كأداة للعثور على المجرمين المعروفين. وفي شهر يونيو الماضي، قامت شرطة ساوث ويلز بإصدار بيان تبرر فيه استخدام هذه التقانة نظراً للدور الذي تلعبه في خدمة “المصلحة العامة” .

في الواقع، غالباً ما تُبرز التقانة المعايير الأخلاقية المختلفة لدى الناس، سواء تعلَّق الأمر بفرض الرقابة على خطاب الكراهية، أو استخدام أدوات تقييم المخاطر لتعزيز الأمن العام.

وفي محاولة لإلقاء الضوء على مدى التباين في المبادئ بين الناس، قام باحثون من جامعة ماساتشوستس للتكنولوجيا (MIT) بابتكار منصة تحمل اسم “الآلة الأخلاقية” بهدف الاستعانة بآراء الجماهير حول القرارات الأخلاقية التي يجدر بالسيارات ذاتية القيادة أن تتبعها. حيث طلبوا من ملايين الأشخاص في مختلف أنحاء العالم أن يُبدوا آراءهم بشأن أشكال متنوعة من المسألة الأخلاقية الكلاسيكية “معضلة العربة (تجربة أخلاقية تفترض وجود عربة قطار متجهة نحو خمسة أشخاص ممددين مع إمكانية تحويل مسارها لتتجه نحو شخص ممدد وحيداً على المسار الثانوي)”، وذلك بأن يختاروا مَن الذي يجدر بالسيارة أن تحاول تفضيله عند وقوع حادث سير، وتُظهر النتائج تبايناً هائلاً بين الثقافات المختلفة، ويمكنك القراءة عن ذلك في هذه المقالة.

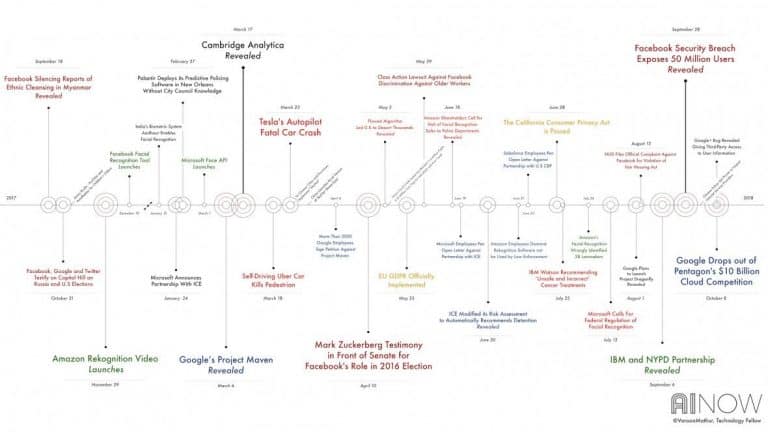

كما أن وضع معايير أخلاقية لن يؤدي بالضرورة إلى تغيير السلوك، ففي شهر يونيو الماضي مثلاً قامت جوجل -بعد موافقتها على إيقاف العمل على مشروع مافن Maven مع البنتاغون- بوضع مجموعة جديدة من المبادئ الأخلاقية الناظمة لمشاركتها في مشاريع الذكاء الاصطناعي المستقبلية. ولم يمضِ سوى بضعة أشهر حتى شعر العديد من موظفي جوجل أن هذه المبادئ قد ضُرب بها عُرض الحائط بالتزامن مع تقديم عرض للحصول على عقد مع وزارة الدفاع الأميركية بقيمة 10 مليار دولار.

وقد خلُصت دراسة حديثة من جامعة ولاية نورث كارولاينا إلى أن دعوة مهندسي البرمجيات لقراءة القواعد الأخلاقية لا يسهم في تغيير سلوكياتهم.

ويقترح فيليب ألستون (باحث القانون الدولي في كلية القانون بجامعة نيويورك) حلاً لطبيعة الأخلاق الغامضة وغير الخاضعة للمساءلة: وهو إعادة صياغة النتائج التي يقودنا إليها الذكاء الاصطناعي باستخدام مفردات حقوق الإنسان. يقول ألستون خلال نفس المؤتمر: “إن حقوق الإنسان واردة في الدستور” ويضيف: “إنها واردة ضمن مشروع قانون الحقوق، وتم تفسيرها من قِبل المحاكم”. ويرى ألستون أنه إذا قام نظام للذكاء الاصطناعي باستبعاد حقوق الناس الأساسية، فيجدر بنا عدم القبول به.

مصدر الصورة: آندرو فيدرمان لصالح معهد الذكاء الاصطناعي الآن للأبحاث

وألستون ليس الوحيد الذي توصَّل إلى هذا الحل، فقبل انعقاد الندوة بأقل من أسبوع، نشر معهد أبحاث البيانات والمجتمع مقترحاً لاستخدام حقوق الإنسان الدولية لضبط الذكاء الاصطناعي، ويتضمن التقرير توصياتٍ للشركات التقنية للعمل مع مجموعات الحقوق المدنية والباحثين، وإجراء تقييمات لأثر حقوق الإنسان على دورة حياة أنظمة الذكاء الاصطناعي الخاصة بهم.

ويضيف ألستون أخيراً: “سنبقى مفتقدين لوجود مرجعية متينة إلى أن نتمكن من إدخال حقوق الإنسان ضمن نقاشات الذكاء الاصطناعي”.